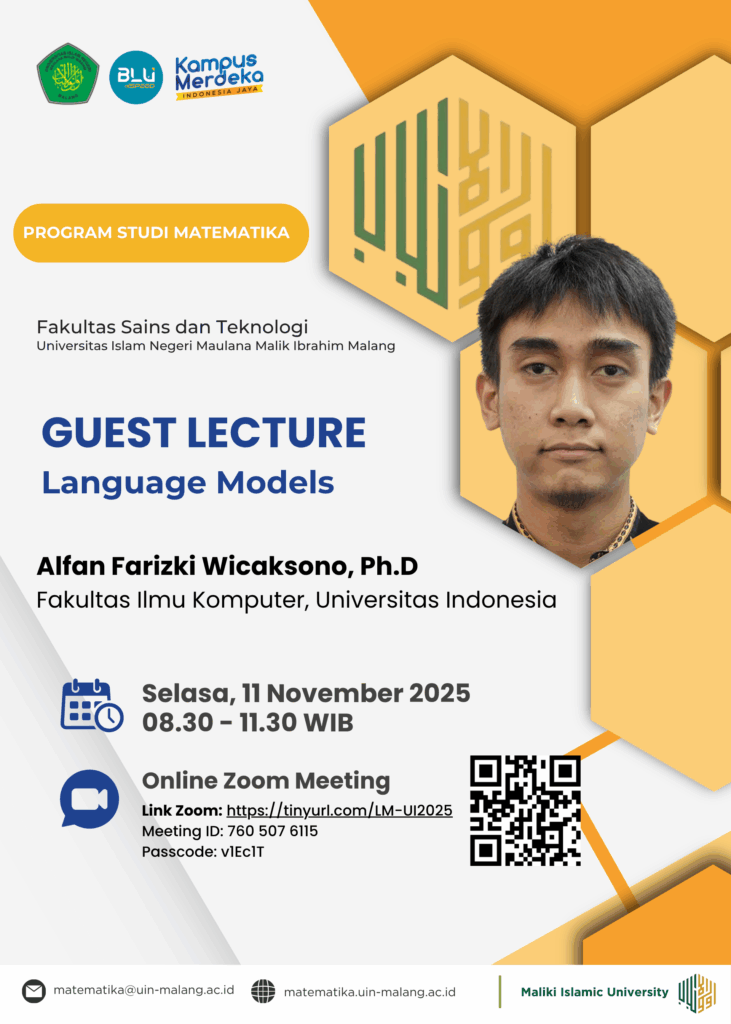

Malang, 11 November 2025 – Program Studi Matematika, Fakultas Sains dan Teknologi, UIN Maulana Malik Ibrahim Malang menyelenggarakan Kuliah Tamu Online spesial yang membahas mengenai Language Model (Model Bahasa), sebuah topik yang banyak dibahas dalam dunia kecerdasan buatan. Acara yang diselenggarakan pada hari Selasa, 11 November 2025, pukul 08.30 WIB ini menghadirkan pakar di bidangnya, Alfan Farizki Wicaksono, Ph.D, Dosen Ilmu Komputer dari Universitas Indonesia.

Dalam sesi yang menarik perhatian banyak peserta ini, Bapak Alfan memaparkan secara mendalam tentang cara kerja fundamental model bahasa, mulai dari konsep dasar hingga pandangan kritis terhadap Large Language Model (LLM) saat ini.

Dasar Probabilitas Berantai

Narasumber menjelaskan bahwa secara esensial, Language Model bekerja dengan menghitung cara probabilitas berantai dari urutan kata di dalam kalimat.

“Cara kerja paling sederhana dari sebuah model bahasa adalah memprediksi kata berikutnya dalam sebuah kalimat. Ini dilakukan dengan menghitung seberapa besar kemungkinan sebuah kata muncul setelah urutan kata-kata sebelumnya,” jelas Bapak Alfan. “Sistem ini menggunakan prinsip probabilitas untuk menyusun teks yang koheren dan kontekstual.”

Model ini, yang telah menjadi fondasi dari banyak aplikasi AI generatif, terus berkembang pesat.

LLM: Deskriptor Token Skala Besar, Bukan Murni Penalaran

Meskipun performa LLM modern (seperti GPT dan sejenisnya) sering diasumsikan memiliki kemampuan reasoning (penalaran) yang mirip manusia, Bapak Alfan memberikan perspektif yang berbeda dan kritis.

Beliau menyampaikan bahwa LLM yang ada saat ini pada dasarnya merupakan bentuk large token descriptor (deskriptor token skala besar) daripada model yang memiliki kemampuan penalaran sejati.

“Pencapaian LLM yang kita lihat adalah hasil dari pemrosesan data teks dalam volume yang sangat besar (triliunan token). Model ini sangat ahli dalam mendeskripsikan, memetakan, dan memprediksi hubungan antartoken berdasarkan pola-pola yang telah dipelajarinya,” tegasnya.

Hal ini menyiratkan bahwa output yang dihasilkan LLM sering kali merupakan reproduksi pola dan struktur yang sangat kompleks dari data latih, bukan murni proses berpikir atau penalaran logis yang independen. Pandangan ini mendorong para akademisi dan praktisi untuk lebih mendalami batas kemampuan LLM dan fokus pada pengembangan mekanisme reasoning yang lebih terstruktur di masa depan.

Prospek Penelitian: Optimasi Training dengan RAGs dan Steering Neuron

Pada sesi penutup, Bapak Alfan menyoroti beberapa topik penelitian terbaru di bidang LLM, khususnya yang berfokus pada efisiensi dan optimasi proses training.

Beliau menyebutkan dua pendekatan utama yang menjanjikan untuk mengurangi biaya dan waktu pelatihan model:

Retrieval-Augmented Generations (RAGs): Pendekatan ini memungkinkan LLM untuk mengambil informasi dari basis data eksternal (pengetahuan faktual) secara real-time saat menghasilkan respons.

“RAGs mengurangi kebutuhan model untuk menyimpan semua pengetahuan di dalam bobotnya. Ini membuatnya lebih efisien, lebih akurat dalam informasi faktual, dan mengurangi hallucination tanpa harus melatih ulang seluruh model,” ujar Bapak Alfan.

Steering Neuron: Ini adalah teknik yang memanfaatkan manipulasi pada neuron tertentu di dalam arsitektur model. Dengan mengarahkan atau ‘menyetir’ perilaku neuron, para peneliti dapat mengontrol output model untuk tujuan spesifik, sehingga mengurangi proses training ulang yang mahal atau fine-tuning yang ekstensif.

Kuliah tamu ini diakhiri dengan sesi tanya jawab yang interaktif, memberikan wawasan berharga bagi mahasiswa dan dosen dalam memahami arsitektur, tantangan, dan arah penelitian di balik teknologi Language Model yang semakin mendominasi lanskap digital.